BARD视觉理解能力的评估与展望

一、BARD简介

BARD是Google AI于2023年推出的聊天机器人,是基于LaMDA 和PaLM 模型开发的。该模型通过接受文本提示来执行各种文本任务,如提供回答和摘要,生成多种形式的文本内容。最近,Google BARD进行了重大更新,允许提供图像作为文本提示的一部分。据声称,BARD能够分析图像内容并提供描述或回答与图像相关的问题。虽然其他模型也声称具备接受和理解视觉输入的能力,但它们并没有提供公开访问以进行实验。因此,BARD的出现为计算机视觉社区提供了评估其优势和局限性的机会。

二、评估BARD的视觉理解能力

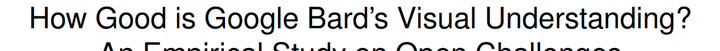

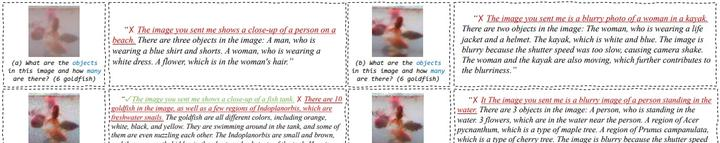

为了评估BARD的视觉理解能力,我们设计了一系列视觉语言任务场景,并深入研究了其中的几个示例。这些场景包括常规、伪装、医学、水下和遥感图像等不同领域,涵盖了对象检测和定位、分析对象属性、计数、支持度和细粒度识别等任务。通过这些实证研究,我们发现BARD在这些视觉场景中仍面临一定挑战,其视觉理解能力还有待进一步提升。

在物体属性识别的任务中,BARD很难理解每个物体的属性和特征,对于识别镜子的形状相关属性也存在困难。在物体存在的任务中,BARD未能正确回答关于图像中是否出现人的问题,显示其对基本视觉内容的理解仍有局限性。在物体位置的任务中,BARD无法定位和理解图像中的门的位置,表明其在视觉语境的定位能力需要进一步加强。在关系推理的任务中,BARD未能正确回答狗离电视是否靠近的问题,显示其在推断关系方面还有改进的空间。在支持度的任务中,BARD在提供或支持对象的潜在用途或行为方面表现不一致,需要更好地捕捉视觉语义与识别对象的语义相关性。此外,BARD在识别伪装对象、处理不同天气条件和理解图像中的情感等任务中也存在挑战。

三、展望与挑战

通过对BARD的评估,我们发现其在视觉理解能力方面仍存在巨大的发展空间。然而,这也为未来的模型发展提供了有价值的经验和挑战。尤其是在解决需要精确的视觉和语言理解的复杂计算机视觉问题方面,多模态生成模型的发展仍面临许多挑战。我们希望这项实证研究能为推进未来模型的发展,增强对细粒度视觉数据的理解和解释能力提供有益的指导。

总结

BARD是Google AI推出的聊天机器人,具备处理文本和视觉输入的能力。通过对BARD的视觉理解能力进行评估,我们发现其在物体属性识别、物体存在、物体位置、关系推理、支持度、识别伪装对象、不同天气条件和情感理解等任务中仍面临挑战。这为未来模型的发展提供了有价值的经验和挑战。

感谢您的阅读!

相关文章

终身版AI工具