OpenAI GPT-4据说基于Mix of Experts架构,具有1.76万亿个参数。

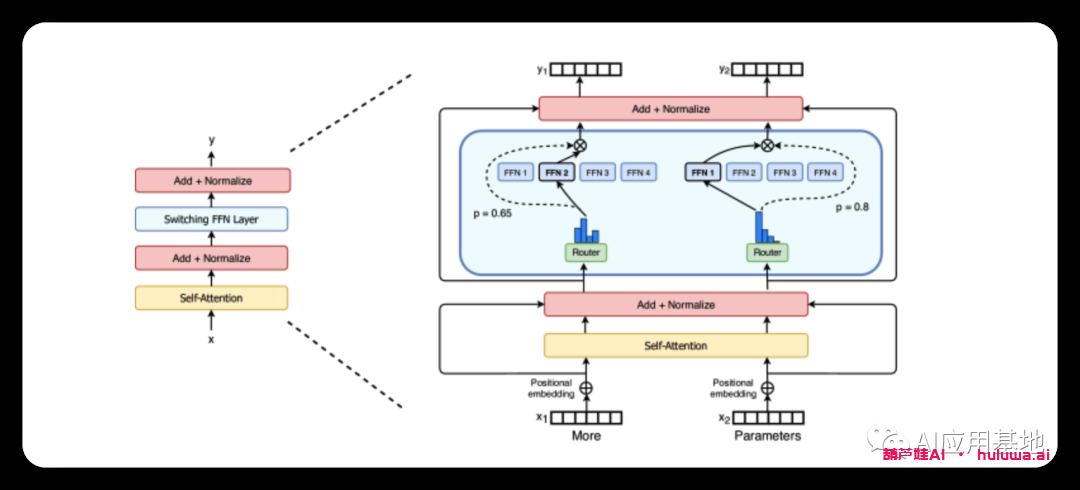

有传言称 GPT-4 基于八个模型,每个模型有 2200 亿个参数,这些模型在专家混合 (MoE) 架构中链接。这个想法已有近30年的历史,之前已经用于大型语言模型,例如Google的Switch Transformer。

MoE模型是一种集成学习,它结合了不同的模型,称为“专家”来做出决定。在 MoE 模型中,门控网络根据输入确定每个专家输出的权重。这允许不同的专家专注于输入空间的不同部分。这种架构对于大型和复杂的数据集特别有用,因为它可以有效地将问题空间划分为更简单的子空间。

OpenAI没有声明,但谣言是可信的

有关GPT-4的信息来自自动驾驶初创公司 Comma.ai 的创始人乔治·霍茨(George Hotz)。霍茨是一位人工智能专家,也以他的黑客历史而闻名:他是第一个破解iPhone和索尼Playstation 3的人。

「乔治·弗朗西斯·霍茨(生于1989年10月2日),别名geohot,是美国安全黑客,企业家和软件工程师。他以开发iOS越狱,对PlayStation 3进行逆向工程以及索尼随后对他提起的诉讼而闻名。自 2015 年 9 月以来,他一直在自己的车辆自动化机器学习公司 comma.ai 工作。 自 2022 年 11 月以来,Hotz 一直致力于深度学习框架 tinygrad。」

其他人工智能专家也在Hotz的Twitter上发表了评论,称他的信息很可能是真的。

开源模型可以从 GPT-4 中学到什么?

该架构可能通过允许不同的团队在网络的不同部分工作来简化 GPT-4 的培训。这也解释了为什么OpenAI能够独立于当前可用的产品开发GPT-4的多模式功能并单独发布它们。然而,与此同时,GPT-4可能已被合并到一个更小的模型中,以提高效率,PyTorch的创始人之一Soumith Chintala推测。

Hotz 还推测,GPT-4 不仅产生一个输出,而且迭代产生 16 个输出,每次迭代都会得到改进。

开源社区现在可以尝试复制这种架构,这些想法和技术已经存在了一段时间。但是,GPT-4 可能已经显示了 MoE 架构在正确的训练数据和计算资源下可以走多远。

Summary 小结

- 据报道OpenAI的GPT-4基于“专家混合”架构(MoE ),包括1.76万亿个参数。

- 此体系结构结合了多个决策模型,对于大型数据集特别有用。

- 这些信息来自人工智能专家乔治·霍茨(George Hotz),并在人工智能社区中获得了信誉。

- 开源开发人员可以尝试复制这种架构,并从 GPT-4 的进步中学习。

相关文章

终身版AI工具